大黑蚊子 发表于 2025-2-20 03:27

说实话我也在琢磨这个玩意儿,几万块钱搞一个这个玩玩,在AI新浪潮初期真的算是一个比较高性价比的学习途径 ...

马鹿 发表于 2025-2-20 21:45

真心羡慕国内了。。。我90年代自己攒过打游戏的计算机。。。

testjhy 发表于 2025-2-20 09:50

社长,美国不是与国内PC价格差不多吗?也仿照沉宝蚊行攒一台呗,

testjhy 发表于 2025-2-20 23:321 _: \' [! d I# r' I

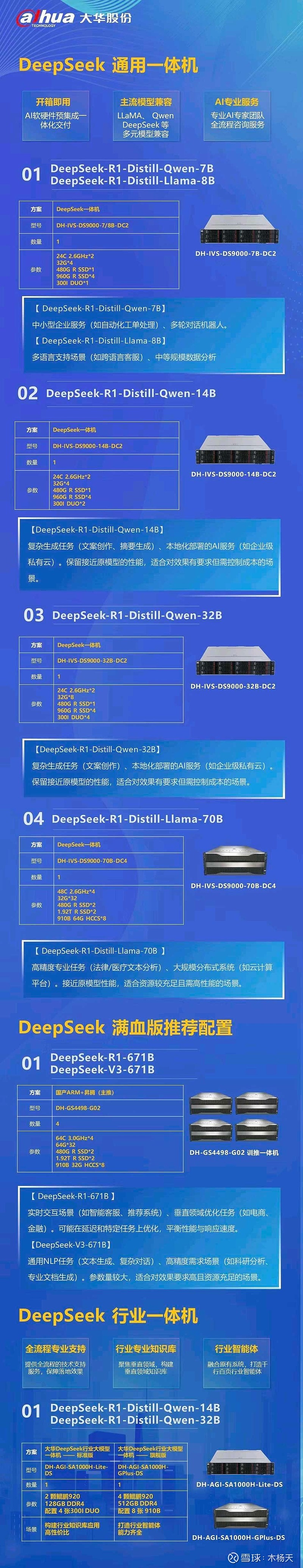

这是大华股份根据国产芯片的一体机,

马鹿 发表于 2025-2-20 23:19

攒了以后干啥呢?

大黑蚊子 发表于 2025-2-20 23:38 B9 r8 ]% o% T K' n9 D' a

大华的这个配置没啥意义,你看跑的都是蒸馏版的7B/14B/32B模型, W5 y% E" {; L

我在自家电脑上搞了一个7B的模型试了下, ...

testjhy 发表于 2025-2-20 23:45

找了一个非剪裁图,看了一个新闻,华为提供方案,有60多家企业响应,大华可能是比较快的,找不到价格,{: ...

大黑蚊子 发表于 2025-2-20 10:38

大华的这个配置没啥意义,你看跑的都是蒸馏版的7B/14B/32B模型. I K6 V- c7 M% n% r5 w" p) ?

我在自家电脑上搞了一个7B的模型试了下, ...

马鹿 发表于 2025-2-20 23:531 f3 W( c2 Q- `3 P/ h# @( i3 l

好奇你攒个模型做啥?

大黑蚊子 发表于 2025-2-20 16:27

说实话我也在琢磨这个玩意儿,几万块钱搞一个这个玩玩,在AI新浪潮初期真的算是一个比较高性价比的学习途径 ...

大黑蚊子 发表于 2025-2-20 23:53, E) A; g+ \( M+ j: k0 V# V+ R$ ^

我要是鼓捣这玩意儿,肯定是找二手硬件啥的,全新设备的价格那还是相当辣手的

打听了一下Intel的至强4代C ...

大黑蚊子 发表于 2025-2-20 11:035 P- o) h& s9 G* g

玩啊,好奇啊,这很可能是通向新世界的大门

有这个条件的话,干嘛不玩?

xut6688 发表于 2025-2-21 05:30

在本地部署满血版的DeepSeek R1, 性价比太低了,还不如用各个云厂商的API。 自己学习,玩一玩用云API就好。 ...

沉宝 发表于 2025-2-21 00:16( k9 O1 p) \ n i1 h! F3 V

这取决于对问题的理解和取舍。首先在大模型计算中,GPU的能力远远强于CPU,即使那个CPU有amx指令加速。所 ...

大黑蚊子 发表于 2025-2-21 14:10

我建议你再看一下KTransformers的相关资料9 h% Z! H" Y/ S5 T8 k

这个玩意儿的本质是在低并发(甚至是单并发)的情况下,高度依 ...

沉宝 发表于 2025-2-22 00:10

欢迎讨论。

9 }" U) n" U# x

首先,个人以为KTransformers的最核心最精华的是抓住了DeepSeek模型参数的稀疏性。DeepSeek ...

大黑蚊子 发表于 2025-3-10 22:251 B3 B0 B3 K. B

刚刚看到一个案例,有个朋友用2686V4 x2 加256GDDR3跑起了671B的Q2.51版本' ?8 a* T0 w6 J$ f

显卡用的是3070M 16G,环境是U ...

大黑蚊子 发表于 2025-3-10 22:25! P p2 P% L. A7 O' C7 b

刚刚看到一个案例,有个朋友用2686V4 x2 加256GDDR3跑起了671B的Q2.51版本

显卡用的是3070M 16G,环境是U ...

数值分析 发表于 2025-3-10 23:42

这里有篇文章是谈万元以下服务器部署DeepSeek-R1 671B + KTransforme的

https://www.pmtemple.com/academy/ ...

大黑蚊子 发表于 2025-3-10 22:258 D' Q/ ~, e4 [; b' v; s; A- i5 e

刚刚看到一个案例,有个朋友用2686V4 x2 加256GDDR3跑起了671B的Q2.51版本

显卡用的是3070M 16G,环境是U ...

孟词宗 发表于 2025-4-15 10:414 w0 @8 N( |- G f

性价比更好的是 HP Z840。这玩意儿有2X Intel Xeon E5-2678 v3 up to 3.1GHz (24 Cores Total),最好的是 ...

nanimarcus 发表于 2025-4-15 12:58

散热的问题,你把机箱敞开,左右两片直接给拆了,开个小风扇对着吹就是了,斜着吹,从前往后,CPU显卡电源 ...

孟词宗 发表于 2025-4-15 14:12

同意风冷,但用不着这样 DIY。可以用 联力 LANCOOL 215 https://lian-li.com/product/lancool-215/。这机 ...

nanimarcus 发表于 2025-4-15 17:35' X7 h# i6 _" N; a% C# h

我有点成见,总认为机箱上的风扇不够有力,呵呵。: N- \- }! b, V9 Q2 f

2 w4 K( u! R8 m

所以总认为机箱敞开了另外架个风扇吹特别有力,至少视 ...

孟词宗 发表于 2025-4-15 21:45

Caseless 的 DIY 电脑现在也挺多的。散热和灰尘啥的不是问题。

nanimarcus 发表于 2025-4-15 23:26

这个确实很赞。, @2 L+ C2 N4 S; ?+ R8 [

第一三张好像放不了全尺寸显卡。

孟词宗 发表于 2025-4-15 11:58" V' z( F7 `' g* G9 C* q w

没那么贵,Amazon 上一条才 $239。16条也就$3,824。

https://www.amazon.com/Tech-2666MHz-PC4-21300-Wo ...

雷声 发表于 2025-4-16 07:278 c# A2 ~$ m9 `& K% P* {

HP Z系列G4以后支持Intel® Optane™ Persistent Memory,买二手的话更便宜。不过表现怎么样就不好说了。 ...

不过这得看 CPU。如果单个 CPU 只支持 768 GB的话,那两个 CPU 最多也就 1.5 TB。大多数旧的 HP Z8 G4 都最多 1.5 TB。

不过这得看 CPU。如果单个 CPU 只支持 768 GB的话,那两个 CPU 最多也就 1.5 TB。大多数旧的 HP Z8 G4 都最多 1.5 TB。

| 欢迎光临 爱吱声 (http://129.226.69.186/bbs/) | Powered by Discuz! X3.2 |